« Tous les chemins mènent à Rome, mais certains sont plus rapides que d’autres.«

Ammener la donnée du point A au point B le plus rapidement possible pour le moins cher possible pourrait résumer la démarche d’intégration idéale. Or il ne faut pas oublier que comprendre ce que signifie la donnée qui va faire ce chemin et à quoi elle va servir l’est tout autant. Si vous intégrez une information, cela doit apporter un bénéfice démontrable.

Les approches à comprendre avant de commencer

Votre choix dépendra des capacités du fournisseur de donnée

L’intégration par batch (ETL/ELT)

C’est l’approche historique : les données sont extraites, transformées puis chargées à intervalles réguliers.

Avantages : robustesse, faible coût, adapté aux volumes importants.

Limites : faible réactivité, dépendance aux fenêtres de traitement.

Pertinent pour des besoins de reporting et d’analyses planifiées qui font appel à des données historiques ( SCD..)

L’intégration temps réel et streaming

Les données sont captées et traitées en continu grâce à des outils comme Kafka ou le Streaming.

Avantages : réactivité immédiate, utile pour la fraude, l’IoT ou la personnalisation client.

Limites : complexité technique, coûts d’infrastructure plus élevés.

Idéal pour les cas d’usage nécessitant une réaction instantanée.

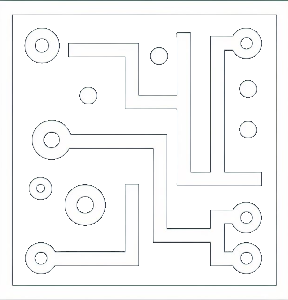

L’approche orientée API et microservices

L’intégration se fait via des API exposées par les systèmes sources et consommées par la data plateforme.

Avantages : flexibilité, standardisation, indépendance des systèmes.

Limites : dépendance à la maturité des applications métiers, gouvernance et RACI des API nécessaire.

Adaptée pour des organisations souhaitant connecter facilement leurs systèmes en continu.

L’hybridation et l’adaptation au contexte

Dans la réalité, les entreprises combinent plusieurs approches selon leurs cas d’usage. Une partie des données peut être intégrée par batch, une autre en temps réel, et certaines via des API.

L’important est de bâtir une architecture évolutive et modulaire, capable de s’adapter aux besoins.

méthodologie

Étape 1 : Analyser le contexte et les cas d’usage

Identifier les besoins métiers (reporting, IA, temps réel).

Évaluer la criticité et la fréquence des données nécessaires.

Étape 2 : Choisir l’approche adaptée

Batch pour des traitements lourds, non urgents.

Temps réel pour des besoins instantanés (alertes, monitoring).

API pour la flexibilité et l’interopérabilité.

Étape 3 : Définir une stratégie hybride

Prioriser l’approche la plus adaptée à chaque cas.

Mettre en place une architecture modulaire permettant de combiner les solutions.

Étape 4 : Sécuriser et industrialiser l’intégration

Documenter les flux et les dépendances.

Mettre en place des outils d’orchestration.

Instaurer un monitoring des performances et de la qualité des flux.

Comprendre les différentes approches

Pour chacune des 4 approches, je vous précise:

Principe de fonctionnement

Cas d’usage adaptés

Étapes de mise en œuvre

Indicateurs de succès (KPI)

Bonnes pratiques

Points de vigilance

Téléchargez la fiche méthodologique

À retenir dans cette section

3 approches classiques

Trois grandes approches existent : batch (ETL/ELT), temps réel (streaming), API/microservices.

Ne vous bloquez pas dans un seul choix

Chaque méthode a ses avantages et ses limites : il faut les adapter aux cas d’usage. L’approche la plus réaliste est souvent hybride.

Modularité

La clé du succès réside dans une architecture modulaire et évolutive, soutenue par un monitoring solide.