« On ne bâtit pas un édifice important sans pierres solides. »

Gardez à l’esprit qu’une plateforme est comme un puzzle géant, elle doit rester modulaire et vous devez pouvoir en changer, l’adapter, la faire évoluer, la régler, et surtout la maitriser. Ne soyez jamais dépendant d’un service tiers, d’un éditeur ou d’une DSI, faute de quoi vous allez faire face à de nombreuses déconvenues

Les 4 choses à considérer avant de commencer

Pensez bien au points ci-dessous

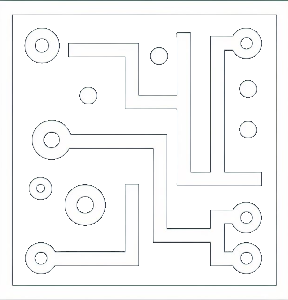

Les couches fondamentales d’une data plateforme

Une plateforme repose généralement sur 4 couches :

Ingestion (collecte et intégration des données depuis les systèmes sources),

Stockage (data lake, data warehouse, base orientée graphes ou temps réel selon les besoins),

Transformation (nettoyage, préparation et mise en forme des données),

Diffusion (exposition via APIs, BI, notebooks ou applications).

Cette structure modulaire garantit flexibilité et évolutivité.

Les services transverses indispensables

Au-delà des couches techniques, une plateforme doit intégrer des services comme :

la gouvernance des données (catalogue, glossaire, traçabilité),

la gestion des accès et des rôles (sécurité, conformité RGPD),

l’observabilité (monitoring, alertes, qualité des données),

l’automatisation (orchestration, CI/CD).

L’intégration avec l’écosystème de l’entreprise

La plateforme n’est pas un silo isolé : elle doit dialoguer avec les systèmes métiers (ERP, CRM, e-commerce, IoT). L’interopérabilité et la connectivité sont des critères essentiels pour assurer la fluidité des flux et éviter les doublons.

La scalabilité et la sécurité comme principes directeurs

Une bonne plateforme doit supporter la croissance des volumes de données, des utilisateurs et des cas d’usage. La scalabilité (technique et financière) et la sécurité (chiffrement, conformité réglementaire, gestion des accès) doivent être intégrées dès la conception.

méthodologie

Étape 1 : Définir les besoins de l’entreprise

Identifier les types de données (transactionnelles, temps réel, externes).

Lister les usages attendus (BI, IA, automatisation, reporting).

Étape 2 : Concevoir l’architecture cible

Définir les couches principales (ingestion, stockage, transformation, diffusion).

Choisir les technologies adaptées (cloud, on-premise, hybride).

Établir un schéma directeur validé par la DSI et les métiers.

Étape 3 : Intégrer les services transverses

Mettre en place un data catalog et un modèle de gouvernance.

Définir la stratégie de gestion des accès (RBAC, IAM).

Installer des outils de monitoring et de data quality.

Étape 4 : Tester et déployer progressivement

Débuter par un périmètre restreint (MVP).

Vérifier la performance, la sécurité et la conformité.

Étendre progressivement aux autres cas d’usage.

Mode d’emploi de la matrice de déploiement

Vous trouverez ci-joint la matrice de déploiement de votre data plateforme, plutôt orienté cloud. Je vous fourrni aussi une notice descriptive.

Ce que contient le fichier XLS :

– Checklist – 133 contrôles opérationnels, déjà structurés par domaines (Landing zone, Réseau, IAM, Clés/Secrets, Observabilité, Data Lake, Warehouse, Ingestion/Orchestration, Data Quality, Catalog/Gouvernance, Sécurité des données, Conformité/RGPD, CI/CD & IaC, MLOps, Résilience/DRP, FinOps).

– Colonnes : Control ID, Phase, Domaine/Composant, Contrôle (Action), Critère de succès, KPI, Responsable (RACI), Preuve attendue, Priorité, Échéance, Statut, Commentaires.

– KPIs – définitions & seuils de référence (ex. ressources IaC ≥95 %, datasets catalogués ≥90 %, RLS/CLS sur 100 % des PII, idle compute <5 %, etc.).

–README – guide d’utilisation rapide.

– Glossaire – termes clés (RLS/CLS, PIM, CMK, IaC, DQ, PIA…).

Ce que couvre la checklist :

Fondations / Landing zone : RBAC, policies deny, Key Vault/KMS & rotation <90j, centralisation logs/SIEM, Defender/équivalents.

Réseau & Private Link : hub-&-spoke, Private Endpoints, Private DNS, WAF pour APIs externes.

IAM : MFA + PIM pour privilèges, managed identities, recertification trimestrielle.

Clés & Secrets : centralisation, rotation automatique, double chiffrement sur PII.

Observabilité : diagnostics complets, alertes SLO/SLA, cockpit FinOps (budgets/alerts, showback).

Data Lake/Stockage : Raw/Silver/Gold, lifecycle/versions, CMK, TLS 1.2+.

Warehouse & Compute : sizing SLA, auto‑scale/auto‑suspend, RLS/CLS & masquage.

Ingestion/Orchestration : patterns standard, idempotence + checkpointing, orchestrateur déclaratif IaC.

Data Quality & Schéma : contrats de schéma, règles DQ, quarantaine des non‑conformités.

Catalog & Gouvernance : glossaire, lineage, classification PII, workflow d’accès.

Sécurité des données : masquage/tokenisation, DLP (egress), tests d’exfiltration.

Conformité / RGPD : PIA, registre des traitements, droits des personnes.

CI/CD & IaC : Terraform/Bicep, SAST/IaC/secret scanning blocking, promotions multi‑envs.

MLOps : registry modèles, dérive & performance, déploiement blue/green ou shadow.

Résilience & DRP : sauvegardes immuables/PITR, multi‑AZ si requis, runbooks incidents.

Fichiers à télécharger :

Comment utiliser la matrice :

Filtrer l’onglet Checklist par Domaine

Assigner les Responsables (RACI),

Échéances et passer le Statut de “À faire” → “En cours” → “Fait”.

Joindre la preuve (lien de runbook, capture de policies, rapport de scans, scripts IaC) dans Preuve attendue ou Commentaires.

Suivre les KPIs (onglet KPIs) dans votre cockpit d’observabilité/FinOps.

Boucler une revue mensuelle pour maintenir le niveau de conformité et ajuster les priorités.

À retenir dans cette section

Quatre strates essentielles

Une data plateforme repose sur quatre couches essentielles : ingestion, stockage, transformation, diffusion.

Portée par les services transverses

Les services transverses (gouvernance, sécurité, observabilité, automatisation) assurent sa robustesse.

Scalabilité et adaptation

La scalabilité et la sécurité ne sont pas des options mais des fondations.